禪宗系統的評論。學分:Zhuang Wang等。

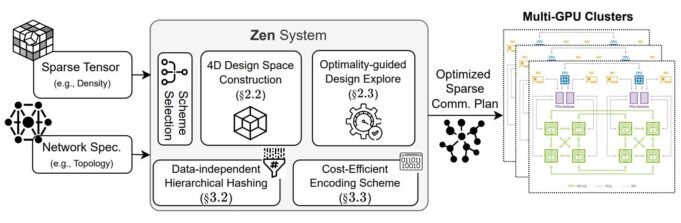

可悲的是,人工智能(AI)以其大資源而聞名,但是一項新的研究可能已經在一種名為ZEN的新通信系統中找到了解決方案,該系統大大改善了教授大語言模型(LLMS)的方法。

賴斯大學的研究小組由Zhuang Van博士研究和計算機科學教授T.S.領導。尤金(Eugene Ng)與另外兩位計算機科學老師的貢獻:Yuk Vanga副教授和Anschumali Srivastava教授。史蒂文斯大學大學的Zhaauoo Suy和Jini Si也為該項目做出了貢獻。

分佈式培訓,耐用和溝通

範說,在分佈式學習過程中可以縮小LLM的兩個階段:計算和交流。

當模型需要減少大量數據時,首先發生。他可以通過消耗時間和計算能力來厭倦系統。在數百個,有時數千個圖形處理單元(GPU)之間進行數據分離有助於解決這個問題。他們分別處理幾個數據樣本,然後將其提交給模型。

當所有這些圖形處理器都必須同步以便他們可以與模型交談並傳達他們學到的知識時,就會發生第二個狹窄的位置。他們需要彼此有效溝通以完成每個訓練通行證,如果他們應該同步的模型梯度非常大,並且通常是他們的經常,則可以放慢腳步。

“先前的決定是發送所有數據。但是實際上,我們觀察到“對話”中的數據在“對話”中的值很多。我們需要一個數據結構來正確提交有關該連接的信息。”

刪除這些零或幾乎為零的值,只放棄在通信過程中同步的相應同步稱為“餐廳”。其餘的值成功稱為“稀有張量”。這是LLM培訓中的常見做法,可以節省努力系統以轉移數十億個其他梯度。但這仍然在溝通中留下了狹窄的位置,團隊集中了研究。

Ng說:“實際上,對如何在分佈式培訓中支持這些罕見的張量的基本了解並不多。” “人們提供了這個想法,但他們不了解處理的最佳方法。我們工作的貢獻之一是對這些罕見的張量的分析來了解他們的行為方式。”

系統映射,結構搜索

實際上,這項研究有三個小時:首先發現了流行模型中稀疏張量的特徵。減少後剩餘的非零梯度並未均勻分佈;它們的張量的位置和密度取決於諸如所使用的訓練模型和數據集之類的因素。

非平等梯度的這種散射導致在通信階段的失衡,從而減慢了同步,因此減慢了學習過程。這種新的理解闡明瞭如何制定最佳的溝通方案,以與稀疏張量一起使用。

他們一旦學會瞭如何接近設計,第二部分就發現了最佳的通信方案。 Van和NG分析了幾種選擇以確定其是什麼。

自從這項研究之前,沒有最佳解決方案,第三步也是最後一步是根據其研究以及該系統在LLM實踐培訓中的應用來創建真實係統,以查看這是否有效。 ZEN是這個系統,在實際LLMS中使用時,她在訓練速度上顯示出急劇的差異。

Ng說:“基本上,我們表明我們可以加速培訓完成之前的時間,因為溝通更有效。…進行一步學習所需的時間要快得多。”

由於經常使用稀疏的張量,並且LLM學習區域非常寬,以至於該發現幾乎可以應用於任何模型,就像它是“備用特徵”一樣。無論是圖像的文本還是生成,如果有稀疏的張量,ZEN都可以加快模型的訓練。

Van不是這一研究領域的初學者。他和NG以前在該項目中合作,以最大程度地減少培訓期間硬件或軟件故障後恢復故障的費用,他們稱之為 雙胞胎– 根據2023年的操作系統原理進入ACM研討會。

範最近提出了他的 紙 在這項新研究中,題為“ Zen:通過稀有性控制的數據同步分佈式學習的可能性”,第19屆USENIX研討會關於操作系統和實施的設計和實施 (吊死) 它是在波士頓進行的。

更多信息:

ZEN:通過數據同步,受控稀有性,擴大分佈式學習的可能性, www.usenix.org/conference/osdi … inpit/wang-chuang

引用:要擊敗AI的狹窄地方:通訊中的創新可以顯著改善AI教學的過程(2025年7月11日)。於2025年7月11日提取。

該文檔具有版權。除了出於私人研究或研究目的的一些公平交易外,如果沒有書面解決方案,就無法再現。內容僅用於信息目的。