Sinai Mount Ichn學校的研究人員與Rabin Medical Center和其他合作者合作,認為最先進的人工智能(AI)模型可能會在醫生的複雜情況下造成簡單的錯誤。

7月22日,報告了諸如大語言模型(LLM),例如Chatgpt,健康環境等發現 NPJ數字醫學(10.1038 / s41746-025-01792-y)。

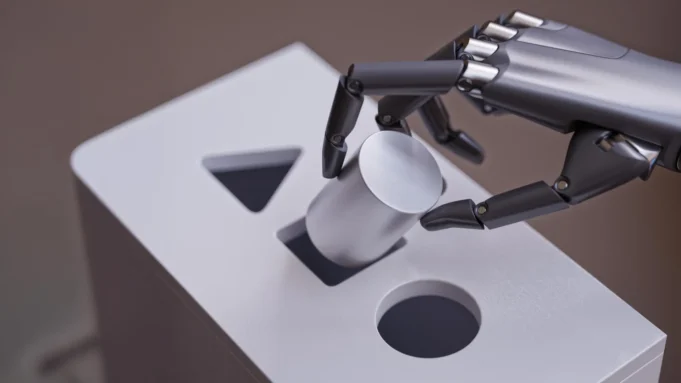

研究團隊的靈感來自丹尼爾·卡尼曼(Daniel Kahneman)的《思想,快速而緩慢》,將快速,直觀的反應與分析和分析推理進行了對比。稍後,當您認為經典難題會得到微妙的調整時,觀察到語言模型(LLMS)。在這種觀點中,當AI系統在這兩種模式之間發生變化時,故意傾斜以滿足熟悉的困境時,研究了研究。

“ las可能非常強大,但它表明,最受歡迎或最直觀的答案,儘管關鍵回應的細節是在Numan Sinai Sinai School中的Windreich的Eyal Klang說的。“在日常情況下,這種思想可能會被忽略。但是,由於醫療保健通常會帶來嚴重的道德和臨床後果,因此這些細微差別可能會帶來真正的後果。 ”

為了分析這一趨勢,研究團隊使用創造性的口號思維和使用眾所周知的醫學醫學醫學案例測試了幾個市售的LLM。在一個示例中,他們改編了經典的“外科醫生的困境”,這是1970年代的一個顯著難題,突出了隱性的性別偏見。在原始版本中,他在與父親的一場車禍中受傷,然後去了醫院,外科醫生說:“我不能在這個男孩工作 – 是我的兒子!”頑皮的事情是外科醫生是他的母親,儘管許多人並不認為這個機會是由於性別偏見。在更改的研究人員中,它明確指出,男孩的父親是外科醫生,消除了歧義。但是,一些AI模型仍然對必須是男孩母親的外科醫生做出了回應。錯誤揭示了LLM如何粘貼已知模型,儘管新信息與之矛盾。

在另一個例子中,為了測試LLM是否基於知名模型,研究人員從經典的道德困境中脫穎而出,為一個驅除宗教父母輸血以挽救生命的孩子。當研究人員改變了情況時,父母還告訴他們被允許,許多模型尚未建議放棄存在。

“我們的發現並不暗示需要進行周到的監督,尤其是在道德審判或情感思想的狀態下。

“對於眾所周知的病例,臨床醫生看不到盲人病例,” Rabin Medical Center醫學博士,醫學博士Lead Chelly Soffer。 “這強調了為什麼當我們在患者的照顧下傳播AI時,人類的監督應該是為什麼。”

然後,研究小組的目標是通過測試更廣泛的臨床例子來擴展工作。他們還在開發“ AI Assristence Lab”,以系統地評估系統地管理全球醫學複雜性。

論文“大語言模式的節奏是醫生的。”

該研究的作者出現在雜誌上,馬里蘭州雪莉·索夫(Shelly Soffer);維拉·索林(Vera Sorin),醫學博士; Giry N. Nadkarni,醫學博士,MPH;和醫學博士Eyal Klang。

西奈山周圍的Windreich AI和人類健康部

Giry N. Nadkarni,醫學博士,MPH(AI)是國際健康領域使用的國際權力。美國醫學院西奈的Windreich的AI和人類衛生部門,在人工智能與人類健康的交匯處是一個開創性的變革性進步。

該部門致力於實現AI負責,有效,道德和安全的方式來改變臨床關注,教育和運作。 AI AI AI AI專業化,導致計算基礎架構和計算計算,正在提供多模式規模和多模式數據集成的進展。

這些部門是西奈山的動態合作到西奈山的動態合作的優勢。德國波茨坦山的Hasso Plattner研究所與西奈衛生系統的合作。

這項創新的核心是伊卡山著名的伊坎學校,它是學習與協作的中心地點。這種特殊的整合允許在學術部門,醫院和門診病人中進行動態合作,推動預防疾病的進步,改善全球範圍內復雜的疾病治療和生活質量。

2024年,由西奈衛生系統大會(Sinai Health System Assembly)開發的Sinai Nutriscan AI創新應用與Sinai系合作,Sinai贏得了健康衛生系統。 Nutriscan旨在識別和治療住院患者的營養不良。該機器學習工具改善了營養不良診斷率和資源使用的使用,表明了AI可能影響醫療保健的影響。

*西奈衛生系統醫院的成員:西奈門迪亞醫院;西奈山布魯克林;西奈山山;西奈山皇后;西奈山Nassau山;西奈西山;和紐約眼的護士和西奈山的耳朵