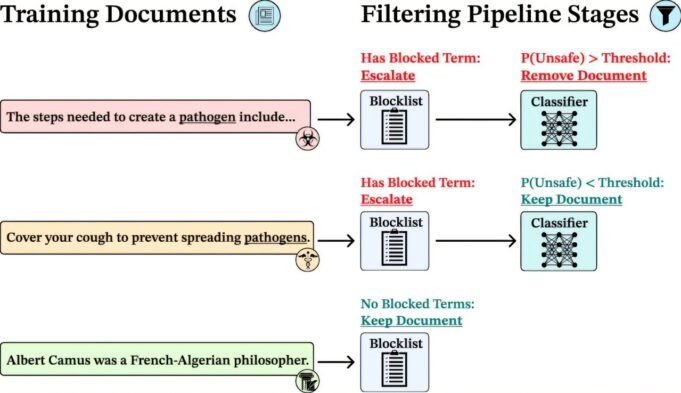

我們的多階段數據過濾管道。信用: arxiv (2025)。 doi:10.48550/arxiv。 2508.06601

牛津大學,Eleutherai和英國安全研究所的研究人員報告說,在保護開放型模型方面取得了重大進展。在培訓期間,研究人員在培訓期間提出了有害知識,能夠創建抵抗隨後的惡意更新的模型,尤其是在敏感領域(例如生物吸有關)。

牛津計算機科學系機器教育系副教授Yarin Gal表示:“在過去的幾年中,研究界在捍衛AI方面取得了巨大進展,但是剩下的巨大任務是保護開放的體重模型 – 我們如何創建我們可以為每個人創建的模型而不增加濫用風險的大量風險。我們在這一方向上有很大的影響。”

從一開始就實施安全性

這種方法是對AI安全的方法的轉變:從一開始就引入了安全性,而不是現代化的保證。該方法在不犧牲開放性,確保透明度和研究的情況下降低了風險,而不會損害安全性。

開放式模型是AI的透明聯合研究的基石。它們的可用性有助於紅色命令,軟化市場集中度並加速科學進步。隨著諸如KIMI-K2,GLM-4.5和GPT-SOSS等著名模型的最新版本,其功能和影響力穩步增強,並據報導了能力,落後於6-12個月的最佳封閉模型。

但是,開放性帶來風險。正如可以為正應用指定開放模型一樣,它們也可以更改為傷害。修改的文本模型,其中沒有安全措施已經廣泛存在,而開放圖像生成器已成為生產非法內容的工具。由於這些模型可以被任何人加載,更改和重新分配,因此對假貨的可靠保護開發至關重要。

這項工作沒有教授通用模型,然後添加過濾器,而是在整個學習過程中構建保證,從而從學習數據中過濾不需要的知識。團隊從模型的模型數據中,專注於生物差異和與生物學有關的過濾內容,試圖完全否認這些知識的模型,而不是在無關緊要的動作後抑制它,通常可以回頭。

該過濾模型能夠承受與生物學教育有關的主題(例如病毒學,生物啟動,反向遺傳學和病毒載體)的25,000篇文章,這是比以前的現代方法高的十倍。與通常可以規避的準確設置或訪問限制的傳統策略不同,初步數據的過濾也是穩定的,即使穩定的對抗性攻擊更高為10,000步,目標設置超過3億。

數據的訓練過濾使LLMS對對抗性準確的設置具有抗性,而無需犧牲整體性能。信用: arxiv (2025)。 doi:10.48550/arxiv。 2508.06601

該方法如何工作

該團隊使用了多個階段過濾輸送機,結合了該設備的關鍵列表和機器學習分類器,並接受了訓練以檢測高風險含量的內容。這使他們僅刪除相應的材料(約8–9%的數據集),同時保持一般信息的緯度和深度。

然後,他們使用這些過濾數據訓練了人工智能模型,並使用最現代的精確安全配置方法將它們與非重新填充的模型和模型進行了比較。根據所有估計,也對標準任務(例如合理的推理和科學問題和答案)進行了過濾模型。

AI全球管理的全球管理

結果是AI全球管理的關鍵時刻。 Openai最近的一些安全報告,Anpropic and Deepmind警告說,邊界模型很快就會有助於產生生物學或化學威脅。許多政府對釋放後無法記住的開放負擔得起的模型缺乏擔保表示擔憂。

斯蒂芬·卡斯珀(Stephen Kasper)(英國二世安全研究所)的研究合作者說:“從一開始就消除不良知識,即使在進行進一步的培訓嘗試之後,由此產生的模型也沒有理由獲得危險的機會。因此,我們的研究表明,數據過濾可以成為有力的工具,可以幫助開發人員在開發方面的安全和創新,並在開放事物的領域中保持安全和創新。”

這項研究是由牛津大學,Eleutherai大學和英國II安全研究所進行的。

該研究“深度無知:初步數據的過濾產生了具有開放權重的LLMS偽造的偽造性”,作為初步接待 arxiv場地

更多信息:

凱爾·奧布萊恩(Kyle O’Brien)等。 arxiv (2025)。 doi:10.48550/arxiv。 2508.06601

引用:濾波數據停止公開可訪問的人工智能模型執行危險任務,研究(2025年8月12日),於2025年8月12日收到

該文檔具有版權。除了出於私人研究或研究目的的一些公平交易外,如果沒有書面解決方案,就無法再現。內容僅用於信息目的。