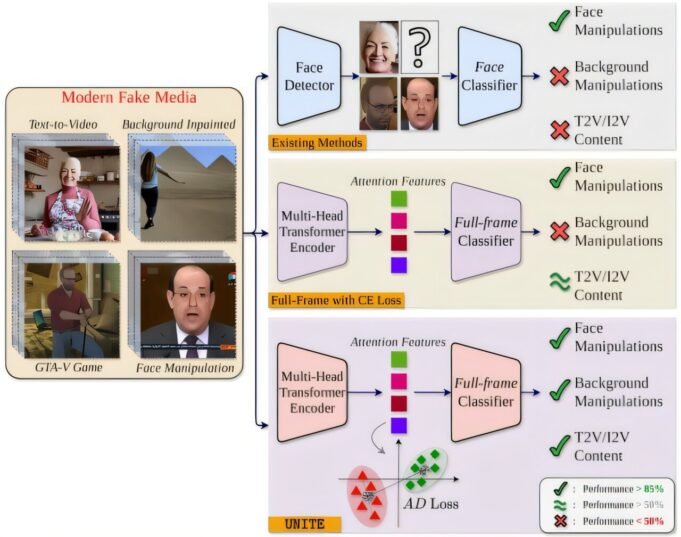

問題的概述:現有的檢測深度功能的方法主要集中在識別由一個人操縱的視頻,其中大多數如果在視頻中發現了臉,則無法得出結論。信用: arxiv (2024)。 doi:10.48550/arxiv.2412.12278

在那個時代,當操縱視頻可以傳播錯誤信息,流氓人並鼓勵傷害時,加州大學河濱研究人員創建了一種新的強大系統來暴露這些假貨。

電氣和計算機工程教授的Amit Roy-Chudkhuri和UCR工程學院的Candle候選人和燭台候選人都來自UCR工程學院和羅斯瑪麗·伯恩斯學院,與Google科學家團結在一起,以開發人工智能模型,該模型在Manipulation遠遠超出掉期和更改的語音時發現了視頻力量。有紙 出版 在 arxiv 預印服務器。

Roy-Chowdhury還是人工智能UC Riverside的研究與教育研究所,UCR新的跨學科研究中心。

他們的新系統稱為通用網絡,用於確定鍛造和合成視頻(UNITE),檢測假貨,不僅研究面孔,還研究完整視頻,包括背景和運動模板。該分析使其成為可以識別面部維護不依賴的合成視頻或註冊視頻的第一批工具之一。

“深度發展,”昆達說。 “他們不再只是交流。

團結開發之所以發生,是因為視頻和圖像視頻中的文本生成已經在互聯網上廣泛訪問。這些用於人工智能的平台使幾乎任何人都可以製作非常有說服力的視頻,為個人,機構和民主本身造成嚴重的風險。

昆達說:“這些工具有多少可用。” “任何具有適度技能的人都可以繞過安全過濾器,並製作公眾人物的現實視頻,談論他們從未說過的事情。”

昆達解釋說,較早的深冰探測器幾乎完全集中在臉部的暗示上。

他說:“如果框架中沒有臉,那麼許多探測器根本不起作用。” “但是虛假形式可能以多種形式發生。改變場景的背景也很容易扭曲真相。”

為了解決這個問題,Unite使用基於變壓器的深度學習模型來分析視頻剪輯。它發現了較薄的空間和臨時矛盾 – 動作通常會錯過以前的系統。該模型依賴於AI的基本結構,稱為Siglip,該結構提取了與特定人或對象無關的特徵。

這種稱為“失去關注”的新教學方法鼓勵系統監視每個框架中許多視覺區域,從而阻止其專注於她的臉上。

結果是一個通用檢測器,能夠標記許多假貨 – 從簡單的面部掉期到沒有任何真實人員的複雜,完全合成的視頻。

昆達說:“這是一種處理所有這些情況的模型。” “這就是使他普遍的原因。”

研究人員在2025年田納西州納什維爾的計算機視覺和样本識別(CVPR)會議上得出了結論,稱為“通用通用合成探測器視頻的途徑:從人或背景操縱到完整生成的AI內容”,其文章,陳述,概述,概述,概述的建築和方法論。

合作者包括Google研究人員Hao Siong,Vicchens Mohanti和Atula Balachandra。

與Google培訓的Google合作提供了對廣泛的數據集和計算資源的訪問權限,用於教授廣泛合成內容的模型,包括從文本或一動不動的圖像獲得的視頻 – 通常是現有檢測器的陰莖的格式。

儘管Unite仍在開發中,但Unite可以在保護視頻虛假信息中發揮至關重要的作用。潛在用戶包括社交網絡平台,對預防病毒操縱視頻的事實和新聞部門的驗證。

昆達說:“人們應該知道他們是否看到自己看到的東西。” “隨著II在偽造現實中變得更好,我們應該在揭示真相時變得更好。”

更多信息:

Rohit Kundu等。在通往通用合成檢測器視頻的途中:代表或背景操作完全生成的AI內容, arxiv (2024)。 doi:10.48550/arxiv.2412.12278

引用:AI系統在面部交流外識別假視頻並改變了演講(2025年7月25日),於2025年7月25日從https://techxplore.com/news/news/2025-07-sientists-tool-fake-fake-videos.html收到

該文檔具有版權。除了出於私人研究或研究目的的一些公平交易外,如果沒有書面解決方案,就無法再現。內容僅用於信息目的。