Entrdings LLM映射反映了自然場景的視覺答案。信用: 自然情報 (2025)。 doi:10.1038/s42256-025-01072-0

當我們看世界時,我們的大腦不僅識別諸如“狗”或“汽車”之類的物體,還可以理解更廣泛的含義,例如,發生的事情,發生的地方以及一切如何連接在一起。但是多年來,科學家們沒有一個很好的方法來衡量這種豐富而復雜的理解。

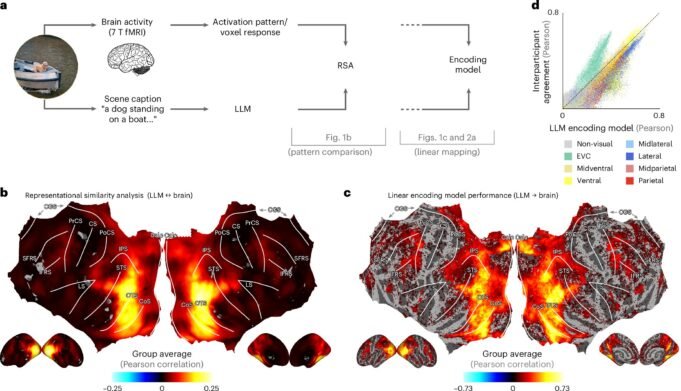

現在 新研究 今天發表在 自然情報蒙特利爾心理學大學副教授,揚·夏斯特(Jan Charest)解釋了他和明尼蘇達大學和德國奧斯納布魯克大學和柏林弗萊恩大學的同事如何使用大語言模型(LLMS)來找出答案。

Mila AI Institute的所有者Charest說:“在這些LLMS-TOT類型的人工智能中吸收了自然場景的描述,站在諸如Chatgpt之類的工具後面,他們創造了一種關於場景意味著什麼的“語言烙印”。”

他說:“這是值得注意的,這些指紋接近記錄的大腦活動模型,而人們看著MRI掃描儀中的相同場景,“像一群孩子在玩耍或城市的大型視野。

Charest說:“例如,使用LLMS,我們可以在句子中解碼一個人剛剛感知到的視覺場景。我們還可以準確預測大腦對食物,地方或場景(包括人臉)的反應,包括人臉,使用LLM中編碼的表示。”

研究人員走得更遠:他們訓練了人工神經網絡以獲取圖像並預測這些LLM指紋,並發現這些網絡在大腦的答案上比當今許多最先進的AI視覺模型更好。

而且,儘管這些可用模型的培訓少得多。

這些“人工神經網絡”的概念得到了機器學習教授蒂姆·基茲曼(Tim Kitzman)和他在奧斯納布魯克大學的團隊的支持。該研究的第一作者是柏林Freie大學的Edrien Dorig教授。

“我們了解到的是,人的大腦可以將復雜的視覺場面表示與現代語言模型如何理解文本非常相似,” Charest繼續對此問題進行研究。

“我們的研究為解碼思想,改善大腦界面並創建更智能的AI系統開闢了新的機會,這些系統像我們一樣“看到”了。

“這些新技術還可以幫助為具有重大視覺障礙的人開發視覺假體。但是最後,這是理解人腦如何理解視覺世界的含義的一步。”

更多信息:

Adrien Doerig等。人腦中高水平的視覺表示與大語言模型保持一致, 自然情報 (2025)。 doi:10.1038/s42256-025-01072-0

引用:LLM可以對應於日常場景中人腦的感知(2025年8月7日)。 2025年8月7日從https://techxplore.com/news/2025-08-llms-human-rain-peceptions-evryday.htm收到

該文檔具有版權。除了出於私人研究或研究目的的一些公平交易外,如果沒有書面解決方案,就無法再現。內容僅用於信息目的。