然而,模型的改進速度遠遠快於理解它們的努力。 Anthropic 團隊承認,隨著人工智能代理的激增,實驗室理論上的犯罪行為越來越接近現實。如果我們不打破黑匣子,它就會摧毀我們。

“我大多數人 生活一直專注於嘗試做我認為重要的事情。當我 18 歲的時候,我從大學輟學去支持一位被指控犯有恐怖主義的朋友,因為我相信當別人不支持別人時,支持別人更重要。當他被判無罪時,我意識到深度學習將影響社會,並致力於探索人類如何理解神經網絡。過去十年我一直在研究它,因為我認為這可能是確保人工智能安全的關鍵之一。 ”

克里斯·奧拉 (Chris Olah) 在 2022 年在 Twitter 上發布了“和我約會醫生”的內容。他不再是單身,但 文件 他寫道,它仍然保留在其 Github 網站上,“因為它對我來說是一份重要的文檔”。

奧拉的描述遺漏了一些事情,包括儘管沒有大學學位,但他是 Anthropic 的聯合創始人。一個不太重要的遺漏是,他獲得了泰爾獎學金,該獎學金向有才華的輟學生頒發 10 萬美元。他在 2024 年的一次採訪中告訴我:“這給了我很大的靈活性,讓我可以專注於我認為重要的事情。”在閱讀《連線》雜誌等文章的激勵下,他嘗試製造 3D 打印機。 “19 歲的時候,沒有人一定有最好的品味,”他承認。然後,在 2013 年,他參加了一系列關於深度學習的研討會並受到了啟發。他在結束會議時提出了一個似乎沒有人問過的問題: 這些系統中會發生什麼?

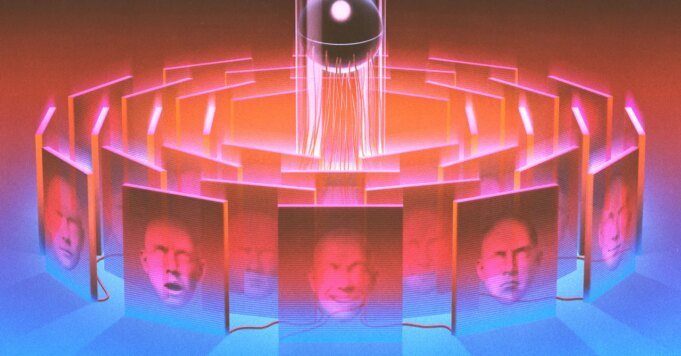

奧拉發現很難讓其他人對這個問題感興趣。 2014 年,當他以實習生身份加入 Google Brain 時,他正在開發一款名為 Deep Dream 的奇怪產品,這是人工智能成像的早期實驗。神經網絡產生奇怪的、迷幻的模式,幾乎就像是毒品軟件一樣。 “我們不明白結果,”奧拉說。 “但他們展示的一件事是,神經網絡中有很多結構。”他總結道,至少有些內容是可以理解的。

奧拉著手尋找這樣的證據。他創辦了一份科學期刊,名為 蒸餾 為機器學習帶來“更多透明度”。 2018 年,他和谷歌的一些同事在 Distill 上發表了一篇題為“The Building Blocks of Interpretability”的論文。例如,他們發現特定的神經元編碼了鬆軟耳朵的概念。從那裡,奧拉和他的同事可以弄清楚系統如何識別拉布拉多獵犬和虎貓之間的區別。他們在出版物中承認,這只是破譯神經網絡的開始:“我們需要使它們具有人類規模,而不是壓倒性的信息轉儲。”

這篇論文是奧拉在谷歌的絕唱。 “谷歌大腦確實有一種感覺,如果你談論人工智能安全,你就不是很認真,”他說。 2018 年,OpenAI 為他提供了組建可解釋性永久小組的機會。跳。三年後,他與 OpenAI 的一群同事一起創立了 Anthropic。