Google DeepMind表示,升級的人工智能模型使機器人能夠完成最複雜的任務,甚至可以利用網絡尋求幫助。在新聞發布會上,Google DeepMind總裁Carolina Parada告訴通訊員,該公司的新人工智能模型正在與機器人一起工作,以便在對物質世界採取行動之前“考慮多個階段”。

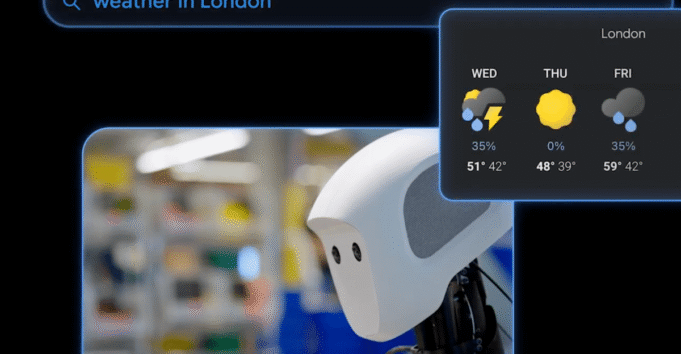

該系統由Gemini Robotics 1.5和Gemini Robotics -R 1.5啟動的Gemini Robotics操作,這是Google DeepMind在3月提供的人工智能模型的更新。現在,機器人可以執行不僅僅是單個任務,例如折疊紙或破譯袋子。他們現在可以做諸如深色和淺色的洗衣店之類的事情,而當前天氣的包裝取決於倫敦,並幫助某人根據專門為特定現場要求設計的在線搜索來對垃圾,肥料和可回收材料進行分類。

帕拉達(Parada)說:“到目前為止,這些模型總體上能夠做得很好,”帕拉達說。 “通過此更新,我們現在從一個說明轉變為真正的理解並解決重大任務的問題。”

為此,機器人可以使用Gemini Robotics -R 1.5模型,該模型促進了對周圍環境的理解,並使用Google搜索等數字工具來查找更多信息。 Gemini Robotics-E 1.5將這些結果轉化為Gemini Robotics 1.5的自然語言指令,從而使機器人可以使用模型願景並理解語言來實現每個步驟。

此外,Google DeepMind宣布Gemini機器人技術1.5可以幫助彼此“學習”機器人,即使它們具有不同的配置。 Google DeepMind發現,提供給Aloha2機器人的任務由兩個機械武器組成,“ Just Work” 而Fernza機器人, 除了 人類機器人阿波羅的apptronik。 Google DeepMind Kanishka Rao說:“這給了我們兩件事:第一個是用一種模型來控制非常不同的機器人 – 包括人形。” “其次,現在所學的技能可以轉移到一個機器人到另一個機器人。”

作為更新的一部分,Google DeepMind通過Google AI Studio中的API Gemini啟動了Gemini Robotics -R 1.5,而只有選定的合作夥伴才能達到Gemini Robotics 1.5。