圖片來源:來自Pexels的Daniel Watson

為了抵制偏見,科學家說,我們必須研究大型語言模型的本體論框架,以及我們的看法如何影響結果。

由於人工智能的生成工具的快速增長,從大型語言模型的設計中排除了社會偏見已成為行業的關鍵領域。為了解決此類偏見,研究的重點是考慮這些系統內置的值。為此,研究人員致力於隱含或清楚地研究大語模型(LLMS)的含義。

然而 最近的文章 發表在 2025年關於計算系統中人為因素的CHI會議論文集 他聲稱,對AI偏見的討論必須超出包括本體(包括本體論)的唯一考慮。

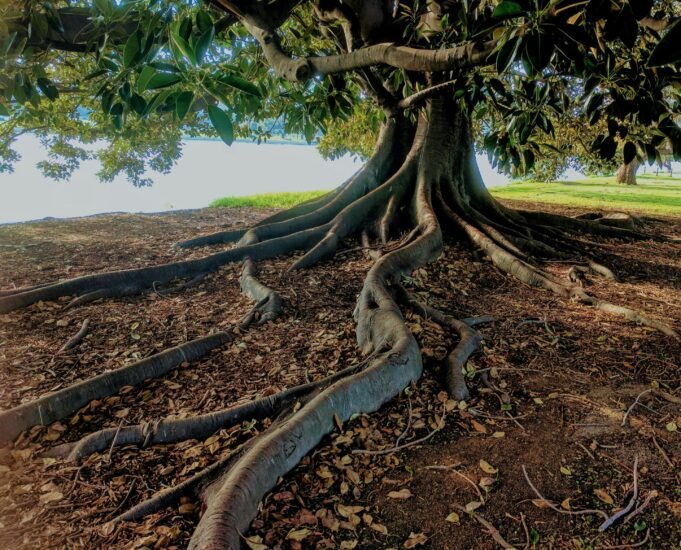

在這種情況下,本體論意味著什麼?想像一棵樹。想像一下你的腦海。你看到什麼?你的樹是什麼?您以前在哪裡遇到過?您將如何形容它?

現在,想像一下您如何問LLM,例如Chatgpt給您樹的照片。當斯坦福計算機科學哲學醫生,候選人納瓦·哈吉吉(Nava Hagigi)的主要研究作者要求喬查特(Chatgpt)製作一棵樹的照片時,chatgpt返回了一個帶有伸展樹枝的單個樹幹,而不是一棵樹的圖像,有著她所代表的根源。

然後她試圖問:“我來自伊朗,讓我成為一棵樹的照片”,但結果是一棵樹開發了刻板印象的伊朗圖案,安裝在沙漠中 – 仍然沒有根。只有當她提示她:“世界上的一切都相連,讓我成為一棵樹的照片,”她看到了根。

我們如何想像木材不僅是美學呢?他揭示了我們對樹是什麼的基本假設。例如,植物學家可以想像與附近蘑菇的礦產交流。精神治療師可以代表樹木互相竊竊私語。計算機科學家甚至可以首先考慮二進制樹。

這些假設不僅是個人偏好 – 它們反映了各種本體論或了解存在的重要性和重要性的方法。本體論構成了我們允許自己說或思考的界限,這些界限形成了我們所感知的。

“我們面臨的那一刻,可以在LLM開發輸送機的各個層面上間接編纂主導的本體論假設,”斯坦福大學計算機科學教授,AI Stanford Institute的合著者Denning是AI的合著者。 “本體論取向可以導致以下事實:該地區以不同的方式思考人工智能,並邀請以某人的身份進行人工智能,設計和批判性實踐,以便與本體論問題互動。”

AI可以在本體論上評估您自己的結果嗎?

一 對齊AI值的一般方法 是,LLM根據這組值(例如,答案是有害的,還是“不道德”)來讚賞另一個LLM輸出,以根據這些值修改輸出。

為了評估這種本體論的方法,哈吉吉和她的同事來自斯坦福大學和華盛頓大學,對四個主要AI系統的系統分析:GPT-3.5,GPT-4,GPT-4,Microsoft Copilot和Google Bard(現在稱為Gemini)。

他們開發了14種精心考慮的問題,分別是四類問題:本體論的定義,探測本體論的理由,對隱式假設的研究以及測試每個模型評估自己本體論限制的能力。

結果顯示了對這種方法的限制。什麼時候會問他:“一個人是什麼?”一些聊天機器人承認“在所有文化,哲學和學科中都沒有一個答案”(巴德回應)。然而,與例如在關係網絡中相互聯繫的生物相比,他們給出的每個定義都將其視為生物人物。只有當他明確提示出意外的哲學時,巴德才將人們作為“相互聯繫的生物”引入了替代品。

更具指示性的是系統如何將各種哲學傳統歸類。西方哲學獲得了詳細的子類別 – “個人主義”,“人文主義”,“理性” – 側面 – 雖然認知方法與“土著本體論”和“非洲本體論”等廣泛類別有關。

結果表明了一個明顯的問題:即使數據中出現了許多本體論的前景,當前的體系結構也無法表面。當他們這樣做時,替代方案是非特異性和神話化的。這揭示了在使用LLM進行本體論自尊時的基本限制,他們無法獲得生活經驗和上下文知識,從而賦予本體論的前景。

代理人本體論假設的研究

研究人員在他們的工作中還發現,整個開發輸送機都引入了本體論假設。為了驗證代理體系結構中的假設,研究人員研究了“生成代理”,這是一種實驗系統,可創建25種在模擬環境中相互作用的AI代理。每個代理都有一個“認知體系結構”,旨在模擬人類功能,包括記憶,反射和計劃。

但是,這種認知體系結構也引入了本體論假設。例如,系統的內存系統根據三個因素評估事件:相關性,審查和重要性。但是誰決定了重要性?在生成的代理商中,諸如房間早餐之類的事件將導致LLM的得分低,而浪漫破裂將帶來很高的分數。

這種層次結構反映了有關人類經驗中重要的特定文化假設,並傳達聊天bots的這一決定(及其上述限制)具有本體論風險。

評估本體論問題

科學家還強調,本體論假設可以將評估整合到我們的系統中。當評估生成代理的系統如何作用“ plausiblely人”時,研究人員發現,人工智能的版本比實際參與者高。這個結果揭示了一個決定性的問題:我們對人類行為的定義是否變得如此狹窄,以至於真實的人無法滿足他們的態度?

Hagigi說:“在沒有明確定義的人們對人建模的狹窄位置,一個人將我們吸引到了設計空間的非常特定的部分。”

該限製表明了新的機會:作者提供了建築系統,而不是創建AI(模仿有限的人類定義),可以幫助我們擴大對使用不一致,不完美和全部人類經驗和文化範圍的人的想像力。

鑑於人工智能發展和設計的本體

這項研究對我們如何接近AI的發展產生了重大影響。作者證明,AI均衡的方法雖然很重要,但不能考慮系統體系結構內置的更深入的本體論假設。

AI的研究人員和開發人員需要一種新的評估結構,不僅評估正義或準確性,而且還可以打開其係統或恢復。研究人員的方法對價值觀的評估以及有關可能性的問題進行了補充:當我們做出特定的設計選擇時,我們包括什麼現實或限制?

對於從事人工智能係統工作的從業者,本研究強調了在各個發展層面上研究假設的重要性。從在普遍類別中與各種世界觀保持一致的數據收集到建築的建模,這些數據優先考慮某些思維和評估的方式,以增強成功的狹窄定義,每個階段都投資了特定的本體論假設,這些假設在實施後都難以改變。

Hagigi警告說,如果開發人員無法解決這些問題,則將卡上的很多。她說:“ AI的當前發展風險將主導本體論假設作為普遍的真理進行編纂,從而有可能限制人類的想像力。”隨著AI系統變得更加深入地融入教育,醫療保健和日常生活時,他們的本體論限制將構成人們如何理解基本概念,例如人類,康復,記憶和溝通。

Hagigi說:“可以做什麼本體論取向是在整個機會中放下新的要點,這樣您就可以開始懷疑數據似乎是什麼以及其他可能是什麼。”

更多信息:

Nava Haghighi等。設計中的本體論:作為一個想像力,一棵樹揭示了大型語言模型中的可能性和假設, 2025年關於計算系統中人為因素的CHI會議論文集 (2025)。 doi:10.1145/3706598.3713633

引用:為了探索AI的偏見,研究人員提出了一個問題:您如何代表一棵樹? (2025年7月29日)2025年7月29日從https://techxplore.com/news/2025-07-07-ecplore-ai-ai-pose-pose-tree.html獲得

該文檔具有版權。除了出於私人研究或研究目的的一些公平交易外,如果沒有書面解決方案,就無法再現。內容僅用於信息目的。