這種名為 VSSFlow 的新模型採用創造性架構,通過單個統一系統生成聲音和語音,並提供最先進的結果。觀看(並收聽)下面的一些演示。

問題

目前,大多數視頻轉音頻模型(即經過訓練從無聲視頻中生成聲音的模型)不太擅長生成語音。同樣,大多數文本轉語音模型無法生成非語音,因為它們是為不同的目的而設計的。

此外,之前將這兩項任務結合起來的嘗試通常基於聯合學習會降低性能的假設,導致系統中語音和音頻訓練發生在不同的階段,從而增加了管道的複雜性。

考慮到這種情況,三名蘋果研究人員與中國人民大學的六名研究人員一起開發了 VSSFlow,這是一種新的人工智能模型,可以在單個系統中從無聲視頻中生成聲音效果和語音。

不僅如此,他們開發的架構的工作方式是語音訓練可以改善聲音學習,反之亦然,而不是互相干擾。

解決方案

簡而言之,VSSFlow 使用了幾個生成式 AI 概念,包括將轉錄文本轉換為音素標記序列,以及學習使用流匹配從噪聲中重建聲音(我們在此介紹過),本質上是訓練模型以有效地從隨機噪聲開始並最終得到所需的信號。

它全部內置於 10 層架構中,將視頻和轉錄信號直接與音頻生成過程混合,使模型能夠在單個系統中處理音頻效果和語音。

也許更有趣的是,研究人員指出,同時訓練語音和聲音實際上 兩項任務的性能均得到提高而不是強迫他們競爭或降低任何任務的整體表現。

為了訓練 VSSFlow,研究人員向模型提供了與環境聲音相結合的無聲視頻 (V2S)、與文字記錄相結合的無聲對話視頻 (VisualTTS) 以及文本轉語音 (TTS) 數據的混合物,使其能夠在單個端到端訓練過程中同時學習音頻效果和口語對話。

重要的是,他們指出,VSSFlow 本身無法在同一輸出中同時自動生成背景音頻和語音對話。

為了實現這一目標,他們在大量合成示例上改進了已經訓練好的模型,其中語音和環境聲音混合在一起,以便模型同時學習兩種聲音應該是什麼樣子。

讓我們讓 VSSFlow 發揮作用

為了從無聲視頻中生成聲音和語音,該模型從隨機噪聲開始,並使用從每秒 10 幀的視頻中獲取的視覺線索來生成環境聲音。同時,轉錄所說內容為生成的語音提供了精確的指導。

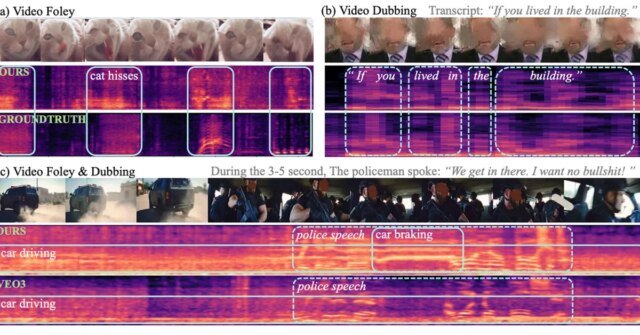

當使用僅針對音頻效果或僅針對語音構建的特定任務模型進行測試時,VSSFlow 在這兩項任務上的表現都具有競爭力,儘管使用單個統一系統,但在幾個關鍵指標上均處於領先地位。

研究人員發布了多個音頻、語音和聯合發電結果的演示(來自 Veo3 視頻),以及 VSSFlow 與幾種替代模型的比較。您可以查看下面的一些結果,但請務必前往演示頁面查看全部結果。

真正酷的是:研究人員已在 GitHub 上公開了 VSSFlow 代碼,並且還在努力確定模型的權重。他們還在努力演示輸出。

至於接下來會發生什麼,研究人員表示:

這項工作提出了一個統一的流模型,集成了視頻轉聲音(V2S)和視覺文本轉語音(VisualTTS)任務,為視頻條件音頻和語音生成建立了新的範例。我們的框架展示了一種有效的條件聚合機制,用於將語音和視頻條件合併到 DiT 架構中。此外,通過分析,我們確定了聯合聲音-語音學習的相輔相成的效果,凸顯了統一生成模型的價值。對於未來的研究,有幾個途徑值得進一步探索。首先,缺乏高質量的視頻語音和音頻數據限制了統一生成模型的發展。此外,未來的一個重要挑戰是開發更有效的聲音和語音表示方法,可以保留語音細節,同時保持緊湊的尺寸。

要了解有關題為“VSSFlow:通過協作學習集成視頻條件聲音和語音生成”的研究的更多信息,請點擊此鏈接。

亞馬遜上的配飾優惠

FTC:我們使用自動會員鏈接來產生收入。 更多的。